工作原理

LLM 是如何工作的?

让我们用简单易懂的方式,一步步了解大型语言模型背后的神奇机制

简单来说

想象一下,LLM 就像一个非常聪明的学生,它通过阅读互联网上的大量文本来学习语言。 这个"学生"不是简单地记忆,而是学会了理解语言的模式和规律。

当你向它提问时,它会根据学到的知识,预测出最合适的回答。 就像你在聊天时会根据上下文选择合适的词语一样。

核心概念解析

神经网络基础

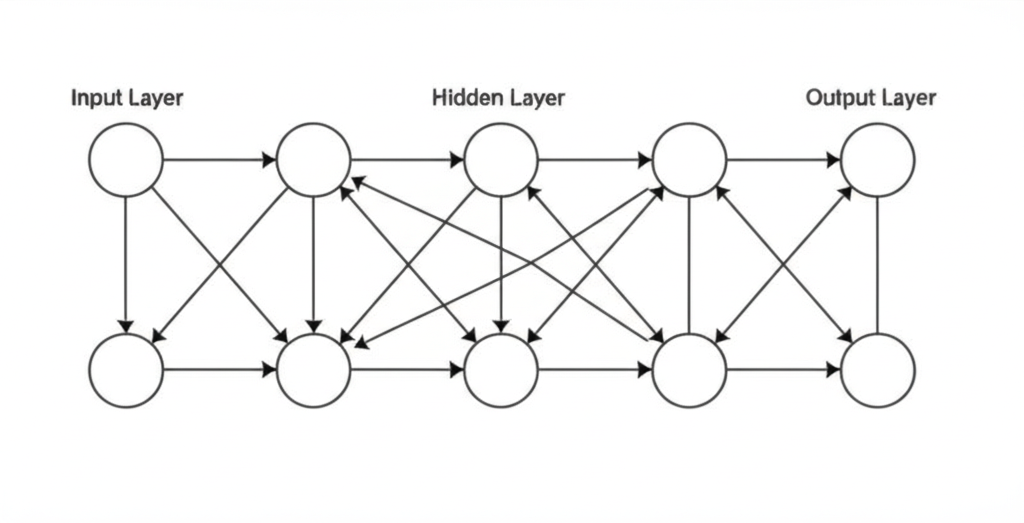

模仿人脑的信息处理方式

就像人脑的神经元

人脑有数十亿个神经元相互连接,形成复杂的网络。神经网络就是用数学方式模拟这个过程:

- 输入层:接收信息(比如一个句子)

- 隐藏层:处理和分析信息(可能有很多层)

- 输出层:产生结果(比如回答或翻译)

简单的神经网络示例

这是一个用 Python 实现的简单神经网络示例:

python

import numpy as np

class SimpleNeuralNetwork:

def __init__(self):

# 初始化权重

self.weights = np.random.random((3, 1))

def sigmoid(self, x):

# 激活函数

return 1 / (1 + np.exp(-x))

def forward(self, inputs):

# 前向传播

return self.sigmoid(np.dot(inputs, self.weights))

# 创建神经网络

nn = SimpleNeuralNetwork()

# 输入数据 [输入1, 输入2, 输入3]

inputs = np.array([[0, 0, 1], [1, 1, 1], [1, 0, 1]])

# 预测输出

output = nn.forward(inputs)

print("预测结果:", output)Transformer 架构

现代LLM的核心技术

注意力机制 (Attention)

想象你在读一本书时,会特别关注重要的词语。Transformer 也是这样工作的:

"小明喜欢苹果因为它很甜。"

模型知道"它"指的是"苹果",而不是"小明"

- 自注意力:理解句子中词语之间的关系

- 并行处理:同时处理整个句子,而不是逐词处理

- 位置编码:记住词语在句子中的位置

训练过程

LLM 如何学习语言

三个阶段的学习

1

预训练 (Pre-training)

就像让学生读遍图书馆的所有书籍,学习语言的基本规律和知识

2

监督微调 (Supervised Fine-tuning)

通过问答对话的例子,教会模型如何更好地回答问题

3

强化学习 (RLHF)

根据人类反馈不断改进,学会给出更有用、更安全的回答

训练数据规模

文本数量:数万亿个词语

训练时间:数周到数月

计算资源:数千个GPU

参数数量:数十亿到数千亿

文本生成过程

LLM 如何一步步生成回答

逐词预测过程

输入:"什么是人工智能?"

步骤1:"人工智能" (预测第一个词)

步骤2:"人工智能是" (基于前面的词预测下一个)

步骤3:"人工智能是一种" (继续预测...)

...

最终:"人工智能是一种模拟人类智能的技术..."